Niemand würde auf die Idee kommen mit verbundenen Augen und den Händen hinterm Rücken zusammen gebunden, durch die Welt zu laufen und erst auf Hindernisse zu reagieren, wenn die Nase diese berührt.

In etwa so geht es aber dem Auto. In ihm übernehmen Beschleunigungssensoren hinter der Stoßstange die Funktion der Nase. Wenn ein Einschlag registriert wird, zünden die Airbags, die Gurte werden gestrafft und eventuell werden Fenster/Schiebedach geschlossen und die Sitze in aufrechte Position gefahren. Dass die zur Verfügung stehende Zeit echt knapp ist, merkt man sofort.

Die Evolution hat uns Menschen Augen gegeben, mit denen wir eine Wand rechtzeitig erkennen und entsprechend reagieren können. Die Physik hat für das Auto Messprinzipien entwickelt, mit welchem es versuchen kann ebenfalls die Umwelt wahrzunehmen. Die Fahrzeugumfeldsensorik hilft dabei, wichtige Informationen über das Fahrzeugumfeld zu sammeln. Die Wichtigsten möchte ich nachfolgend vorstellen.

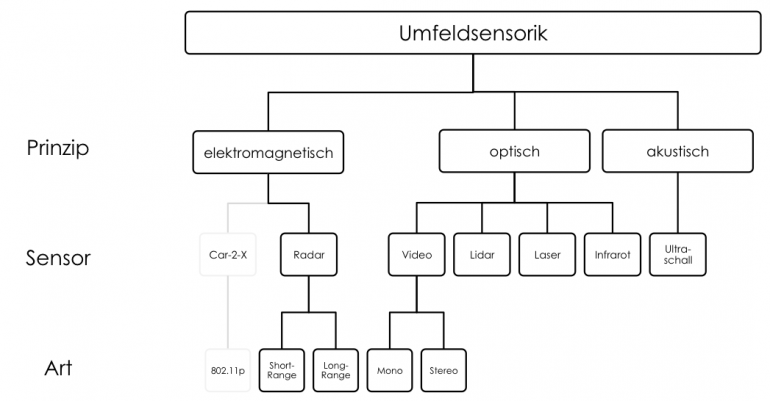

Arten der Umfeldsensorik

Die Einteilung kann in die physikalischen Prinzipien hinter dem Sensor erfolgen. Ein Sensor hat immer die Aufgabe, ein Hindernis in der Umgebung des Fahrzeugs zu erkennen. Idealer Weise liefern Umfeldsensoren

- einen Ort (Koordinaten x, y, z oder Abstand & Winkel)

- Abmessung (Länge, Breite, Höhe) und

- Geschwindigkeit (längs-/quer oder relativ)

des Objekts zurück.

Dabei sind alle Sensoren zur Hinderniserkennung als ‘autonome Fremdortung’ eingestuft, d.h. vom Fahrzeug werden Hindernisse ohne deren Hilfe erkannt. Die zukünftig immer mehr in den Fokus rückende Car-2-X Kommunikation bildet eine Ausnahme, denn sie ist eine kooperative Fremdortung, das Hindernis ‘meldet’ sich aktiv beim Fahrzeug oder gibt Antwort.

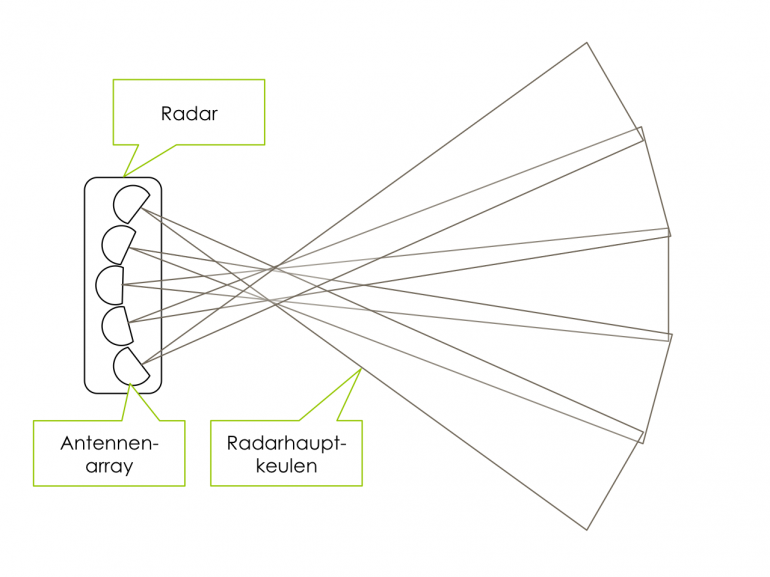

Radar

Ein Radar hat seinen Namen von der Abkürzung Radio Detection and Ranging und funktioniert über das Aussenden einer elektromagnetischen Welle und dem Auswerten des Echos. Dabei wird in der Fahrzeugindustrie ein frequenzmoduliertes Dauerstrichradar (FMCW-Radar) eingesetzt. Dies zeichnet sich dadurch aus, dass die Frequenz der ausgesendeten elektromagnetischen Welle ständig rampenförmig geändert wird. Aus der Laufzeit der Welle und dem Frequenzunterschied der zurückkommenden Welle können mit Hilfe des Doppler-Effekts gleich 2 Messgrößen direkt ermittelt werden:

- Abstand

- Geschwindigkeit

Eine Winkelauflösung (um zu erkennen ob ein Objekt links/rechts/gerade vom Fahrzeug ist) wird nur dadurch erreicht, dass mehrere Antennen halbmondförmig angeordnet sind. Die Winkelauflösung ist eher schlecht, weil die Radarkeulen relativ breit sind und Objekte zwischen den Keulen ‘hin & her’ springen.

Das Radar wird als Long-Range Radar (typisch mit 77GHz) für die adaptive Geschwindigkeitsregelung eingesetzt und als Short-Range Radar (typisch mit 24GHz) als Ein-/Ausparksensor bzw. für den Nahbereich. In folgendem Video sieht man sehr gut, wie die Rohdaten aus einem Radar aussehen.

Das Radar ist eines der wichtigsten Systeme modernen teilautonomer Fahrzeuge und Assistenzsysteme.

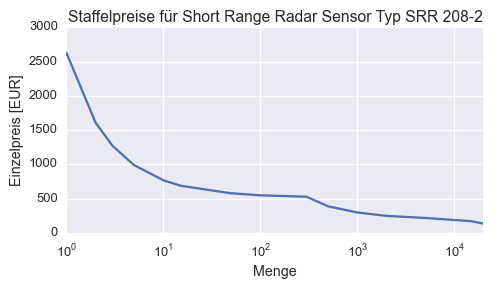

Die Preise richten sich extrem nach der Abnahmemenge. Einen sollte man offensichtlich nicht nur kaufen.

Einzelpreise für Short Range Radar Sensoren von Continental (Stand: 08/2015)

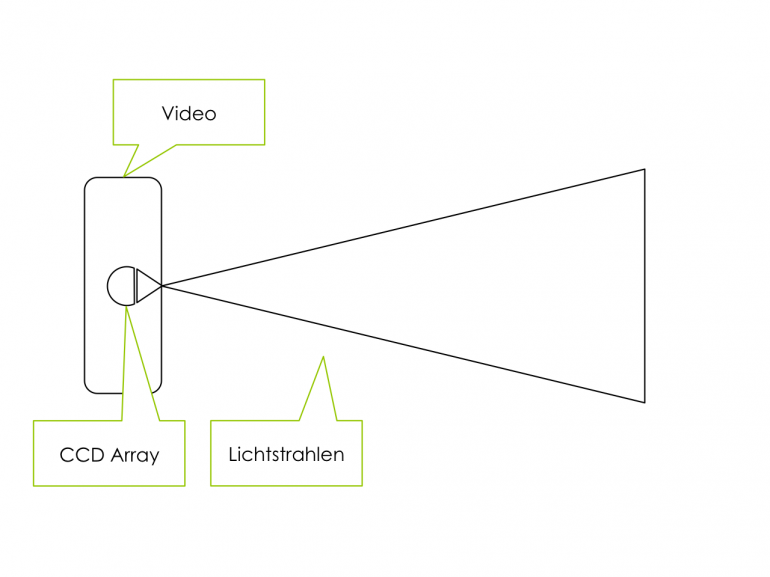

Mono-Video

Hierbei wird über eine Videokamera ein Graustufenbild erfasst und entsprechend weiterverarbeitet. Z.B. werden Kanten im Videobild gesucht, die auf ein Fahrzeugumriss oder eine Fahrspurmarkierung hindeuten. Anschließend werden Plausibilisierungsalgorithmen und Filter genutzt, um daraus Umfeldinformationen zu gewinnen. Typische Kameras erfassen 752×480 Pixel mit 60fps. Um eine Änderung von einem zum nächsten Bild zu erkennen (für optischen Fluss), vergehen also mindestens \(t=2\cdot\frac{1}{12}s\approx0.2s\).

Da ein Video eine 2D Darstellung einer realen 3D Umgebung ist, muss auf eine Dimension verzichtet werden. Das heißt, dass bestimmte Informationen (z.B. wie weit weg ein Fahrzeug ist), nur über Annahmen (z.B. wie breit ein Fahrzeug ist) geschätzt werden können.

Mathematisch wird jede Position \(x, y, z\) der realen Welt auf eine Position \(u, v\) auf dem Kamerachip abgebildet (was dann die Pixel im Bild sind). Drei Koordinaten werden auf zwei Koordinaten reduziert.

Es geht eine Information verloren: Die Tiefeninformation. Folgende Animation verdeutlicht die Problematik. Es ist der Blick einer Kamera auf ein Hindernis. Es wird 2x angenähert und wieder Abstand gehalten, oder?

Blick einer mono Kamera auf ein vorausfahrendes Fahrzeug

Was in der Kameraperspektive aussieht wie 2x die gleiche Bewegung, ist in echt 1x Abstand verringern (distance change) und 1x Größe des Objekts (scale change) verändern. Der Überblick über die Situation zeigt es:

Blick auf die Situation: Ein mal tatsächlich Annäherung, dann aber Größenänderung des Hindernis, für eine Monokamera nicht zu unterscheiden

Man kann dies als Mensch auch mal probieren und sich 1 Auge zu halten. Es wird schwer Abstände zu schätzen. Dies gelingt im Allgemeinen nur, weil das Gehirn aus Erfahrung weiß, wie groß etwas ist und man darüber einen Abstand schätzen kann. Dies wird auch in Algorithmen zur Bildverarbeitung eingearbeitet, in dem z.B. Vergleichsdatenbanken von Fahrzeug-Heck-Ansichten integriert sind.

Der Vorteil der Videosensorik ist aber, dass sie sehr sensibel auf Änderungen in der Bildfläche reagiert (also sich etwas quer zur Fahrtrichtung bewegt) und über entsprechende Algorithmen (z.B. Optischer Fluss) diesbezüglich wertvolle Informationen liefert.

Der Hauptvorteil von Videosensorik ist der Preis! Unschlagbar günstig. Neue Algorithmen, vor allem Deep Learning, haben die Kameras so mächtig gemacht, dass heutzutage sogar Notbremsassistenten damit arbeiten können. Siehe Vortrag von MobileEye.

Stereo-Video

Stereo-Video ist die logische Weiterentwicklung von Video und setzt auf 2 Kameras, welche in einem bestimmten Abstand zueinander sind. Daraus lässt sich auch die dritte Dimension (der Abstand zu einem Hindernis) wieder aus dem Videobild berechnen.

Daimler nutzt diesen Ansatz z.B. im so genannten “6D Vision” System:

Dabei werden im Videobild “Objekte” mit gleichem Abstand gesucht, die sich von einem zum nächsten Bild bewegen. Anhand der Position \(\left[x, y, z\right]\) und der Geschwindigkeit \(\left[\dot x, \dot y, \dot z \right]\) ergibt sich zusammen ein 6-Dimensionaler Vektor für jedes Objekt, welcher Informationen über die geschätzte Position des Objekts in Zukunft ermöglicht. Dabei wird typischer Weise eine Vorhersage für die nächsten 0.5 Sekunden getroffen und mit den neu eintreffenden Bildern der Stereokamera die Objektbewegungshypothese immer wieder verfeinert.

Stereo-Video ist eines der wichtigsten Systeme modernen teilautonomer Fahrzeuge.

Infrarot

Infrarot bezeichnet ein System, welche Licht im infraroten Spektrum aussendet und entsprechend verarbeiten kann.

„Electromagnetic spectrum c“ von Horst Frank / Phrood / Anony – Horst Frank, Jailbird and Phrood. Lizenziert unter CC BY-SA 3.0 über Wikimedia Commons.

Dieses System wird für Nachtsichtassistenten eingesetzt.

Die Weiterverarbeitung erfolgt ähnlich zu Videosensorik.

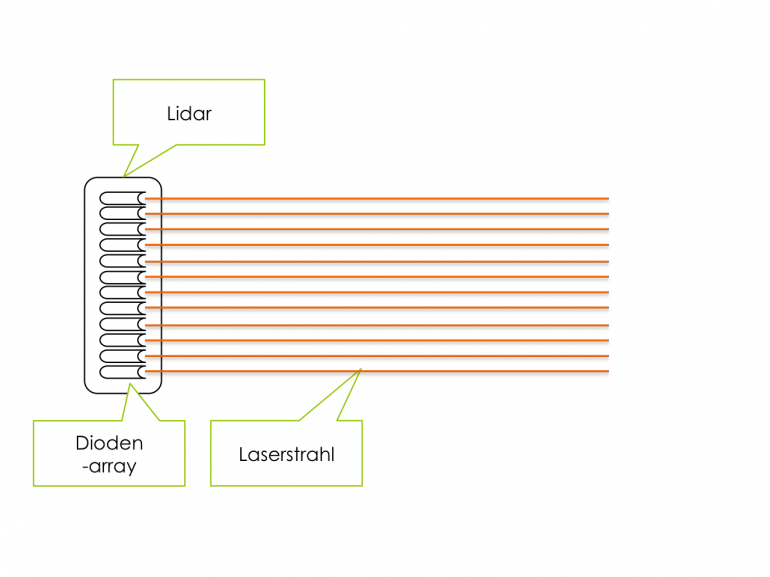

Lidar

Lidar steht für Light Detection and Ranging und bezeichnet die Verfahren, bei denen ein Lichtstrahl (typisch mit 905nm Wellenlänge) ausgesendet wird und über die Laufzeit und Lichtgeschwindigkeit eine Entfernung berechnet werden kann.

Dabei wird oft mit Lidar der Sensor bezeichnet, bei welchem nur Dioden-Arrays und keine beweglichen Teile verwendet werden.

Der Sensor wird oft für City-Break Assistenten für Stop&Go Funktionen eingesetzt.

In naher Zukunft kann man mit 360° Lidar-Sensoren rechnen, welche ähnliche Funktionen wie heutige Velodyne HDL Laserscanner ermöglichen, aber keine beweglichen Teile mehr haben und kostengünstiger sind. Firmen wie Velodyne, Quanergy und Sick arbeiten mit Hochdruck an diesen Sensoren, da sie der Schlüssel zu hochautomatisierter Fahrt sind.

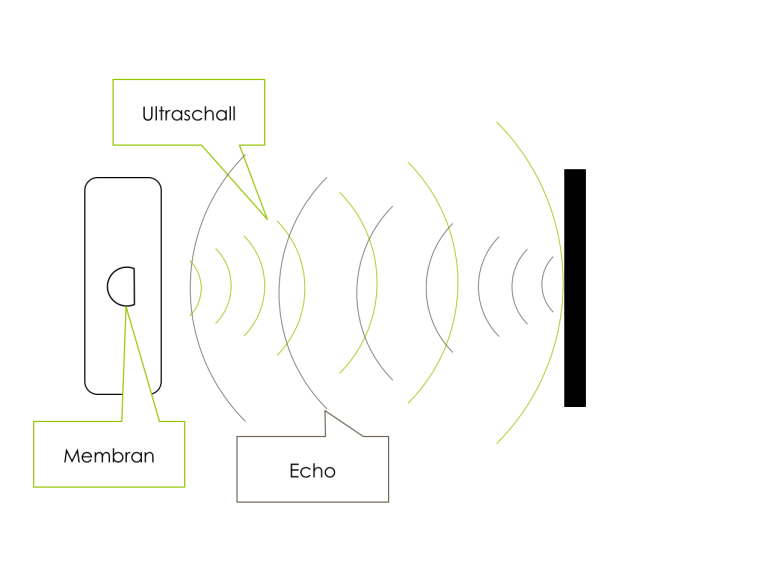

Ultraschall

Ultraschallsensoren haben eine relativ eingeschränkte Reichweite (<10m) und breite Keulen und sind daher hauptsächlich als Einparksensoren oder Totwinkel-Sensoren nutzbar.

Sie werden auch zur Vermessung von Parklücken für Einparkassistenten eingesetzt oder auch zur Kollisionsvermeidung beim Valet Parking.

Sie sind ein wichtiger und günstiger Baustein zur 360° Rundumsicht für Fahrzeuge, vor allem im Nahbereich.

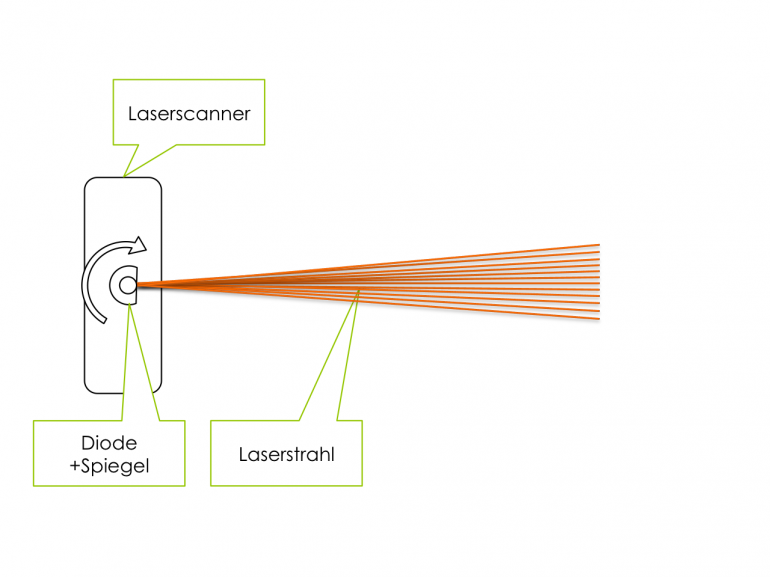

Laserscanner

Ein Laserscanner ist genau genommen auch ein Lidar bzw. funktioniert nach dem Lidar Prinzip. Die Bezeichnung wird aber oft genutzt, um einen Sensor zu betiteln, welcher mit einer Diode und rotierenden Spiegeln arbeitet. Bekannte Vertreter sind z.B. der Velodyne HDL-64E (z.B. Google Self Driving Car) oder der ibeo Lux.

Der Vorteil des Laserscanners ist die grandiose Auflösung in Entfernung und Winkel, weshalb er für die Umfelderfassung der geeignetste Partner scheint.

Der Laserscanner wird bei Deutschen Automobilherstellern derzeit nicht in Serien eingesetzt.

Zusammenspiel verschiedener Sensoren

Da jeder Sensor Vor- und Nachteile hat, werden verschiedene Sensortypen gemeinsam eingesetzt. Dabei gleicht ein Sensor die Nachteile eines anderen aus. Im Zusammenspiel, nämlich durch Sensordatenfusion, ergibt sich ein besseres Ergebnis zur Umfeldwahrnehmung.

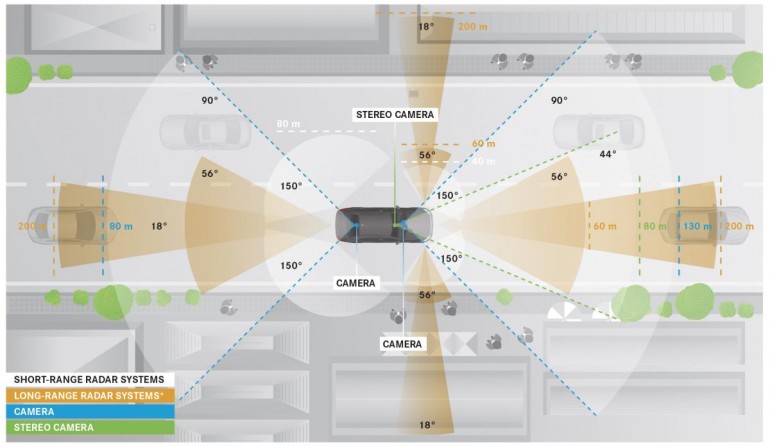

Ein typisches seriennahes Setup kann bei der Vollautonomen Fahrt auf den Spuren von Bertha Benz von Daimler entdeckt werden:

Daimler Intelligent Drive: (Stereo-)Video, Short- & Long Range Radar sowie Ultraschall liefern die Datengrundlage für Algorithmen und Umfeldmodelle

Vergleich Radar vs. Laserscanner

Die Aufgabe der Umfeldsensorik ist es, eine möglichst genaue Aussage zur Umgebung zu treffen. Das heißt, sie soll dem Fahrzeug Informationen über die Position von Hindernissen geben. Da alle Sensoren prinzipbedingt fehlerbehaftet sind, d.h. einen wahren Wert + Messrauschen ausgeben, kann von nachfolgenden Algorithmen nicht direkt die Ausgabe der Sensorwerte genutzt werden.

Eine gängige Methode ist die Annahme, dass die Sensormessungen normalverteilt um den wahren Wert “rauschen”. Es werden immer mehrere Sensormessungen verarbeitet und fusioniert. Dabei ist entscheidend, dass die Standardabweichung der Messung klein wird. Die Varianz der erkannten Objektposition ist ein Entscheidungskriterium für das Eingreifen von Assistenzsystemen. Eine geringe Varianz ist dabei durch bessere Sensoren (weniger Rauschen) oder dem Fusionieren von mehreren Sensoren mit unterschiedlichen Stärken/Schwächen zu erreichen.

Im Folgenden soll beispielhaft für ein Radar und einen Laserscanner ein quasistatisches Ziel (d.h. weder Sensor noch Ziel bewegen sich) erkannt werden.

Rohmessdaten eines Radar-Sensors

Visualisierung der Rohmessdaten eines Radar im zeitlicher Ablauf incl. 2D Normalverteilung der Messwerte | CC-BY-SA2.0

Schön zu erkennen ist, dass die Messwerte “hin & her” springen, obwohl sich das Hindernis nicht bewegt. Dies ist prinzipbedingt durch die Breite der Radarkeulen nicht genauer zu erfassen.

Die Messwerte werden anschließend mit einer Normalverteilung approximiert. Da das Objekt in der x-y-Ebene zu lokalisieren ist, ergibt sich eine Multivariante-Normalverteilung. Umso schmaler und höher diese ist, umso besser (genauer) die Positionsermittlung. Für die weitere Verarbeitung in Algorithmen auf dem Fahrzeug ist nur noch die Glockenkurve mit ihren Parametern relevant (Kovarianzmatrix und Mittelwerte).

Zu erwähnen ist noch, dass der Radar die Geschwindigkeit des Objekts als direkte Messgröße erfassen kann, was ein Vorteil ggü. dem Laserscanner ist, der die Geschwindigkeit über numerische Differentiation zweier Positionsmessungen ermitteln muss.

Rohmessdaten eines Laserscanners

Zum Vergleich wurde das gleiche Hindernis gleichzeitig mit einem Laserscanner detektiert. Die Visualisierung zeigt nur einen Laserstrahl.

Visualisierung der Rohmessdaten eines Laserscanners (nur 1 Strahl) im zeitlichen Ablauf incl. 2D Normalverteilung der Messwerte | CC-BY-SA2.0

Offensichtlich ist die wesentlich geringere Varianz der Positionsmessungen, was sich dann auch auf die Höhe der Normalverteilung auswirkt. Nochmal: Umso schmaler und höher, umso besser! Eine Vergrößerung des Zielbereichs zeigt dies noch mal eindrucksvoll:

Vergrößerung des Zielbereichs der Visualisierung der Rohmessdaten eines Laserscanners (nur 1 Strahl) im zeitlichen Ablauf incl. 2D Normalverteilung der Messwerte | CC-BY-SA2.0

Die grundsätzliche Aufgabe der Umfeldsensorik, Hindernisse zu lokalisieren, erfüllt der Laserscanner um Magnituden besser als das Radar. Und Google fährt ja auch mit einem Laserscanner als Sensor rum. Weshalb ist dieser nicht der Quasistandard unter der Umfeldsensorik?

Für Forschung und Algorithmenentwicklung ist der Laserscanner das Maß aller Dinge. Auch bei den deutschen Fahrzeugherstellern wird ein Velodyne eingesetzt. Für Serienanwendungen ist er allerdings nicht uneingeschränkt geeignet. Dies aus zwei wesentlichen Gründen:

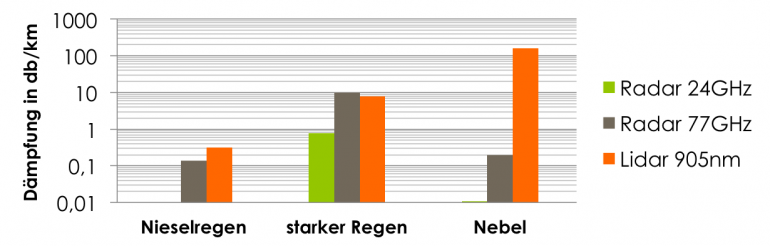

Witterungsabhängige Dämpfung der Signale

Ein Fahrzeug muss auch bei Nebel oder Regen funktionieren, weshalb Assistenzsytem, die nur auf Sensorik nach optischen Verfahren basieren, anfällig ggü. diesen Witterungseinflüssen sind.

Ein Maß für die Einflüsse ist z.B. die Dämpfung des Signals, d.h. wieviel schwächer es pro Kilometer wird. Eine Dämpfung von 0db/km wäre ideal, aber das gibt es nicht.

Dämpfung verschiedener Sensoren nach Umwelteinfluss. Zu beachten die logarithmische Skalierung. Weniger ist besser! Quelle: [Klein, Lawrence A.: Sensor and Data Fusion – A Tool for Information Assessment and Decision Making. SPIE – The International Society for Optical Engineering, 2004 (Signal Processing – Digital Techniques). – ISBN 0–8194–5435–4], Eigene Darstellung

Detektion von kleinen Hindernissen im innerstädtischen Verkehr

Es ist relativ einfach auf einer Autobahn vorausfahrende Fahrzeuge zu erkennen. Wesentlich komplizierter wird es, wenn man sich in den urbanen Raum begibt. Hier stehen eine Vielzahl an Hindernissen bereit, die die Sensoren und Algorithmen vor erhebliche Schwierigkeiten stellen.

Radfahrer/Fußgänger mit Radar

Ein Radfahrer oder Fußgänger hat sehr geringe Reflexionseigenschaften für elektromagnetische Wellen des Radars. Das kann dazu führen, dass ein Fahrradfahrer von einem Radar überhaupt nicht erfasst wird. Die geringe Winkelauflösung und Öffnungswinkel des Radars sowie das Phänomen der Phantomobjektbildung (was heraus gefiltert werden muss), macht ihn nicht unbedingt zu einem verlässlichen Partner im städtischen Umfeld.

Gleich zwei der genannten Einschränkungen können in folgendem Video beobachtet werden:

Der Fußgänger, welcher auf die Fahrbahn läuft, wird vom Radar nicht erfasst (zu dicht dran, zu wenig Reflexion, zu weit außerhalb der Radarhauptkeulen), ein manueller Bremseingriff ist notwendig. Etwas später im Video weicht der vorausfahrende Audi nach rechts aus. Auf Grund der geringen Winkelauflösung und der widersprüchlichen Informationen, welches nun das vorausfahrende Fahrzeug ist, schaltet sich das System präventiv ab (zu hören am *piep*).

Daher werden Stop & Go Assistenten für den innerstädtischen Bereich auch gern mit Lidar Sensoren angeboten.

Radfahrer/Fußgänger mit Laserscanner

Der Laserscanner hat auf Grund seiner sehr hohen Winkelauflösung und exakten Abstandsmessung eine wesentlich höhere Detailgüte. Eine so genannte Punktwolke kann nach charakteristischen Merkmalen durchsucht werden. Auf die Vielfalt der Algorithmen soll an dieser Stelle nicht eingegangen werden. Eindrucksvoll ist sicherlich dieses Video von Google:

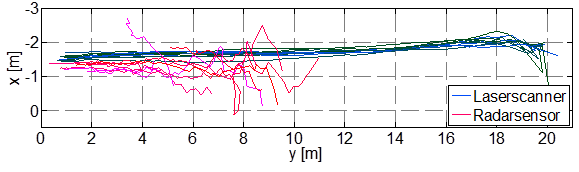

Vergleich Radar vs. Laserscanner zur Fahrradfahrerdetektion

Höringklee hat 2013 in seiner Diplomarbeit untersucht, wie Laserscanner und Radar Fahrradfahrer detektieren können. Dabei näherte sich ein Fahrrad den Sensoren (bei Koordinate 0, 0):

Fahrradfahrer nähert sich den Sensoren (bei 0,0) – Draufsicht. Abbildung: Hochschule für Technik und Wirtschaft Dresden, Labor für Fahrzeugmechatronik, Julius Höringklee

Die qualitativen Unterschiede zwischen Radar & Laserscanner sind offensichtlich.

Design und Integrationsmöglichkeit

Es lassen sich alle Sensortypen prinzipiell in’s Gesamtfahrzeug integrieren.

Dabei ist allerdings anzumerken, dass fast alle Sensoren sensibel auf Verschmutzung reagieren. Das heißt, dass Schnee, Dreck oder Matsch die ausgesendeten Signale so stark dämpfen kann, dass die Algorithmen entscheiden die Assistenzfunktion zu deaktivieren. Vor allem die optischen Verfahren (Laserscanner, Video) sind anfällig.

Vollautonome Fahrt ohne Laserscanner?

Bei den genannten Vorteilen und dem eindrucksvollen Video des Google Self Driving Car in der Stadt, kommt man unweigerlich zu dem Punkt, an dem man sich fragt: Ist es überhaupt möglich vollautonom zu fahren ohne Laserscanner?

Ja.

Die Deutschen Hersteller haben, anders als vielleicht in Palo Alto, mit allen Wetterbedingungen zu rechnen und müssen die Systeme so entwickeln, dass sie sich nur bei wenigen (Wetter-)Situationen deaktivieren. Die Akzeptanz der Käufer wäre sonst noch geringer. Auf Autobahnen und relativ eindeutigen Straßen ist eine vollautonome Fahrt praktisch schon möglich, wird allerdings noch softwaremäßig verhindert. So fordern die meisten Systeme, dass die Hände am Lenkrad belassen werden müssen. Der Algorithmus, der dies überprüft, lässt sich umgehen.

(Haftungsfragen werden in den nächsten Jahren mit Sicherheit in Präzendenzfällen geklärt werden)

Um im innerstädtischen Verkehr und vielleicht sogar völlig ohne Mensch an Board – also wirklich Vollautonom – unterwegs zu sein, wird noch einiges an Entwicklungsarbeit notwendig sein.

Die Algorithmen werden besser, die Sensoren werden besser, die Rechner werden schneller, die Möglichkeiten werden zahlreicher. All das wird dazu führen, dass es auch ohne Laserscanner möglich sein wird.

Allerdings bin ich der Meinung, wird es nicht ohne kooperative Ortung funktionieren, d.h. das Objekt (Mensch, Radfahrer, …) muss über geeignete Hilfsmittel aktiv mitteilen, was los ist.

Nachfolgend ein paar Beispiele:

Blick in die Zukunft

Disclaimer: Ich halte nicht viel von Vorhersagen über die Zukunft, da nicht die technischen Möglichkeiten eine Entwicklung entscheiden, sondern auch gesellschaftliche oder gesetzliche Regelungen. Dies ist eine rein technische Betrachtung.

5G – Mobilfunk der nächsten Generation

Am Vodafone Stiftungslehrstuhl an der TU Dresden wird am Mobilfunk der nächsten Generation gearbeitet, welche eine Latenzzeit von nur noch 1ms sowie einer hohen Verfügbarkeit aufweisen soll. Damit wäre es möglich eine Art virtuelle Schutzblase um Menschen herum zu schaffen, die in Echtzeit an alle Fahrzeuge meldet, wo sich ein Mensch befindet und in welche Richtung er geht. Das Fahrzeug ist somit frühzeitig darüber informiert, dass ein Mensch auf die Straße läuft.

Zustandserfassung von Personen

Schon heute in Serie ist die permanente Zustandserfassung von Menschen. Der Apple M7 Motion-CoProzessor kann zwischen Laufen/Radfahren/Sitzen/Rennen unterscheiden. Würden diese Informationen über 802.11p (also Car-2-X Kommunikation) ausgetauscht, ergäbe sich ebenfalls eine virtuelle Schutzblase, welche das Auto aktiv darüber informiert, dass ein Mensch in der Umgebung dabei ist, auf die Straße zu rennen.

Diese Verfahren haben außerdem den Vorteil, dass keine so genannte Line of Sight notwendig ist, das Fahrzeug also nicht erst “sehen” muss, das etwas hinter einem geparkten Bus/Häuserecke hervor kommt.

Die deutschen Hersteller forschen intensiv an diesen Verfahren, wie auf der Projektwebseite Ko-FAS.de nachgelesen werden kann. Ein Blick auf die Abschlusspräsentation ist ebenfalls interessant.

Car-2-X Kommunikation

Wenn Fahrzeuge autonom gesteuert werden, können sie ihre berechnete Trajektorie (also der Weg den sie befahren werden) mit anderen Fahrzeugen teilen. Dann könnte eine Kreuzung die Geschwindigkeiten der Fahrzeuge steuern und somit eine Kollisions- und Ampelfreie Fahrt ermöglichen.

Das nachfolgende Video zeigt dies etwas überspitzt:

Doch die Forschung dazu läuft schon.

Digitale Karte

Nicht zuletzt mangelt es derzeit auch an einer detaillierten digitalen Karte. Kaum zu glauben, aber ja! Um im urbanen Raum sicher fahren zu können, benötigen Fahrzeuge detaillierte Karten, die über das hinaus gehen, was derzeit flächendeckend zur Verfügung steht.

Zusätzliche Informationen, die nötig wären, um sich selbst zu lokalisieren bzw. sicherer fahren zu können sind beispielsweise:

- Koordinaten von Bordsteinkanten

- Koordinaten der Fahrbahnmarkierungen

- Fahrspuren (Breite, Anzahl, …)

- Koordinaten von Laternenmasten, Ampeln, Schildern

- Stop-Linien

- Fußgängerüberwege

- …

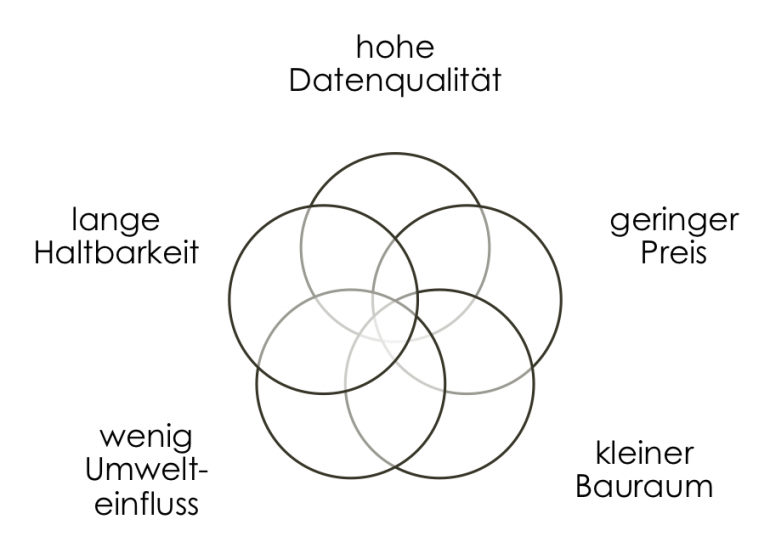

Preis/Bauraum/Verfügbarkeit/Haltbarkeit

Letztlich ist es (leider) so, dass nicht die beste technische Lösung in die Anwendung kommt, sondern auf viele Faktoren geschaut werden muss. Der Preis ist mit Sicherheit sehr relevant (Laserscanner sind teuer!), aber auch der Bauraum, ob bewegliche Teile nötig sind (beim Laserscanner rotiert ein Spiegel) und wie lange die Systeme den harten Einsatz im Fahrzeug durchstehen.

Zielkonflikt beim idealen Umfeldsensor

Titelbild: Velodyne High-Def LIDAR unter CC-BY2.0 Lizenz von flickr.com

12 Comments

Ein sehr guter Artikel, der einem einen Einstieg in das Thema gibt und die grundlegenden Prinzipien aufzeigt.

Das Lidar bei Uber war jetzt wohl nicht so der Bringer… nahezu baugleich wie bei Google – wie Google vor Gericht genug oft betont hat. So ein Auto ohne Lenkrad… darf auf keinen Fall zugelassen werden!

Hi AAARAGORN,

es lag nicht an der Sensorik sondern an der Softwareauslegung. Hier:

https://www.ntsb.gov/news/press-releases/Pages/NR20180524.aspx

damit du nicht mehr im Dunkeln tappst. Autonome Fahrzeuge werden definitiv zugelassen, freu dich drauf.

Super, vielen Dank für den tollen Artikel!

Hallo,

ein wirklich super aufschlussreicher Artikel.

Herzlichen Dank dafür !!!